Warum werden Crawler verwendet?

Seit 1993 sind die ersten Crawler im Einsatz, damals noch um die Dimensionen bzw. das Wachstum des Internets zu erheben. In Bezug auf diesen Einsatz stehen selbst mächtige Webcrawler auf verlorenem Posten, denn durch das exponentielle Wachstum kommen die Programme nur noch schwer hinterher. Daher verlagerte sich der Einsatz auf die Sammlung von Seiten und deren Kategorisierung.

Anfänglich war diese Kategorisierung noch sehr einfach und beschränkte sich meist auf bestimmte Themenbereiche. Dazu wurden sogenannte Meta-Tags verwendet, in denen der Inhalt der Seite mit einigen Schlagwörtern beschrieben wurde. Die erste Suchmaschine, der Webcrawler, der 1994 startete, verwendete diese Technologie.

Mittlerweile ist die Anzahl an Suchmaschinen angestiegen und damit auch die Anzahl an Crawlern. Sie verursachen etwa 40% des gesamten Traffics weltweit. Zudem wurde die Kategorisierung deutlich verbessert und beispielsweise ein Ranking der einzelnen Seiten eingeführt wurde. Durch die Sortierung der Seiten nach Relevanz konnte das Suchergebnis deutlich verbessert werden.

Wie funktionieren Crawler?

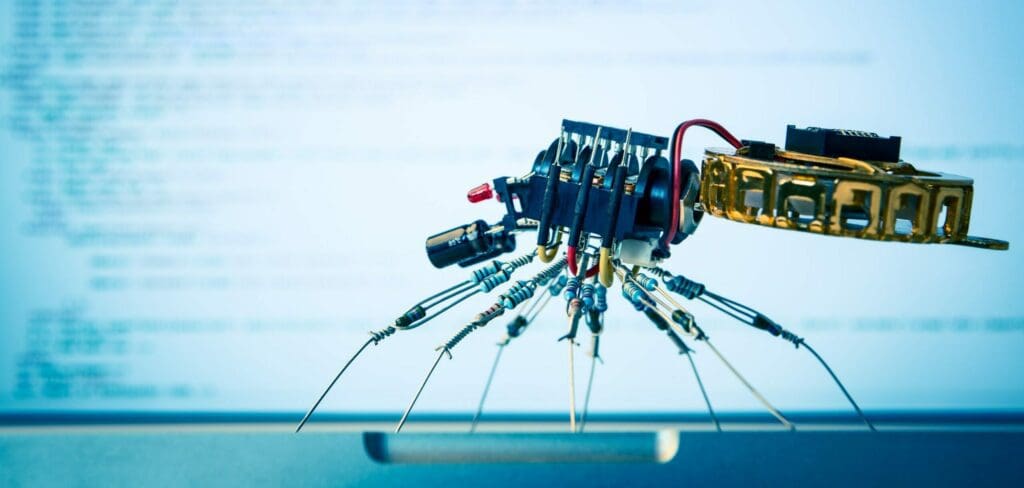

Crawler sind spezielle Bots, die autonom immer wieder die gleiche Aufgabe durchführen. Die Aufgabe bei Crawlern ist Seiten zu besuchen, URLs abzuspeichern und diese nach und nach zu besuchen. Der Crawler arbeitet sich so von Seite zu Seite und speichert dabei auch den zurückgelegten Weg ab. Theoretisch könnte so ein gesamtes Netz der Seiten aufgrund ihrer Verlinkungen erstellt werden.

In der Praxis ist dies jedoch meist unrealistisch, da auch bei den Verlinkungen von den Crawlern nur die wichtigsten Links angesteuert werden. Dadurch erreicht der Crawler irgendwann ein Ende und startet seine Aufgabe wieder von vorne bei einer neuen Seite. Nicht nur der gesamte Weg bzw. die Meta-Daten werden von den Crawlern gesammelt, sondern auch weitere Informationen wie etwa E-Mail-Adressen auf den besuchten Seiten oder Nachrichten von News-Feeds.

Verschiedene Arten an Crawlern

Unter den Crawlern gibt es verschiedene Arten, die beispielsweise nach bestimmten Themen suchen. Allgemeine Crawler haben im Fokus ein möglichst breites Spektrum, wo hingegen fokussierte Crawler nur thematisch relevante Links verfolgen. Sie suchen sich dadurch denn für sie idealsten Weg zur das Netz und speichern alle Informationen der relevanten Seiten ab. Crawler werden deshalb auch gerne zum Data-Mining verwendet, wodurch sie beispielsweise auch gerne für Datenbanken mit vielen unterschiedlichen Dokumenten verwendet werden.

Eine spezielle Form unter den Crawlern sind sogenannte Harvester. Deren einziger Sinn ist es, möglich viele E-Mail-Adressen zu finden. Über den mailto-Link können dann Spam-Mails versandt werden. Daher ist eine gängige Praxis, entweder Kontaktformulare anzubieten oder bei der Angaben von E-Mail-Adressen nicht das @-Zeichen zu verwenden, sondern „at“ zu schreiben, um sich vor unerwünschten E-Mails zu schützen. Ausgereifte Crawler können dies jedoch mittlerweile entsprechend interpretieren und wandeln das ausgeschriebene „at“ automatisch in das Zeichen um.

Eine der jüngsten Formen, sich vor dem Sammeln der E-Mail-Adresse durch Crawler zu schützen, ist die Adresse als Grafik einzubetten und mit dem entsprechenden mailto-Link zu verbinden. Diese Form ist auch bedienerfreundlich, da der Nutzer selbst nicht mehr das ausgeschriebene Zeichen ersetzen muss.

Wann stoßen Crawler an ihre Grenzen?

Effiziente Crawler sind bis zu einem gewissen Maß lernfähig und liefern dadurch auch verhältnismäßig gute Ergebnisse. Manchmal stehen jedoch auch Crawler vor verschlossenen Türen, besonders, wenn sich Informationen beispielsweise hinter Portalen mit Zugangsbeschränkungen befinden oder diese nur über Suchmasken abgerufen werden können. Deshalb kann auch der Großteil des Internets noch immer nicht erfasst werden.

Ein weiteres Problem ist das Sammeln von Informationen durch Crawler selbst, das besonders Datenschützer beschäftigt. Diese sind vehement gegen das wahllose Sammeln von Daten, weshalb oft bewusst Crawler behindert werden.

Beim sogenannten Cloaking wird dem Crawler eine andere Seite angezeigt als dem normalen Besucher. Dies führt dann natürlich auch zu Problemen, wenn Seitenbetreiber darauf angewiesen sind, über Suchmaschinen gefunden zu werden. Daher wird diese Technologie überwiegend bei Seiten verwendet, die zwar öffentlich sind, jedoch nicht von einer breiten Masse gefunden werden sollen.

Ein weiteres Problem, die Crawler in ihrer Arbeit massiv beeinträchtigen, sind sogenannte Teergruben. Diese wurden geschaffen um schlechte Bots, die nur darauf abzielen, Adressen für Spam-Mails zu sammeln, zu behindern. Bei Teergruben wird die Antwortzeit bewusst hoch gesetzt und die Informationen nur sehr langsam an den Crawler übermittelt.

Welche Vorteile und Nachteile haben Crawler?

Der Nachteil der Crawler besteht darin, dass sie gegenüber einer menschlichen Kategorisierung der Relevanz noch immer große Defizite besitzen. Zwar wird in Kombination mit anderen Algorithmen und Bewertungsverfahren das Ranking immer wieder verbessert; Seitenbetreiber, die allerdings von Besuchern leben, versuchen dies immer wieder zu umgehen und das Ranking zu pushen.

Im Gegenzug dazu fallen Seiten, die nicht für das Internet bzw. Crawler optimiert werden, einfacher durch den Raster. Daher bieten viele Suchmaschinenbetreiber die Möglichkeit, Seiten manuell einzutragen, wodurch in Zukunft die Seite automatisch immer wieder besucht wird. Weiterleitungen sollten daher auch vermieden werden und beispielsweise nur die richtige Seite mit Inhalt eingetragen werden.

Unumstritten bieten Crawler für den Nutzer den größten Vorteil, denn ohne sie wäre es nicht möglich, eine selektierte Auswahl an Suchergebnissen zur Verfügung zu stellen. Dennoch sollte man sich nicht nur auf das beste Ergebnis verlassen, sondern auch noch andere Seiten ansteuern bei der Suche nach Informationen. Das Internet besteht mittlerweile aus unzähligen einzelnen Seiten und ohne die Hilfe von Suchmaschinen wäre es kaum mehr möglich, sich umfassend zu informieren.

Zusammenfassung

Crawler sind spezielle Programme, die das Internet systematisch durchsuchen, um Informationen zu sammeln und an Suchmaschinen weiterzugeben. Ursprünglich dienten sie der Ermittlung der Größe des Internets, heute sind sie ein unerlässliches Instrument zur Indizierung und Kategorisierung von Webseiten. Crawler sind für etwa 40% des weltweiten Internettraffics verantwortlich.

Die Funktionsweise von Crawlern ist relativ einfach: Sie besuchen Webseiten, speichern URLs und folgen Verlinkungen. Dabei sammeln sie nicht nur Meta-Daten, sondern auch spezifische Informationen wie E-Mail-Adressen und News-Feeds. Es gibt verschiedene Arten von Crawlern, darunter allgemeine und themenspezifische, sowie solche, die hauptsächlich für Data-Mining oder das Sammeln von E-Mail-Adressen eingesetzt werden.

Obwohl Crawler effizient sind, stoßen sie auf Grenzen. Sie haben Schwierigkeiten beim Zugriff auf Inhalte hinter Paywalls oder Zugangsbeschränkungen und können daher nicht das gesamte Internet erfassen. Außerdem gibt es ethische Bedenken hinsichtlich des Datenschutzes und Techniken wie Cloaking oder Teergruben können ihre Arbeit erschweren.

Vorteile und Nachteile der Nutzung von Crawlern sind vielfältig. Sie ermöglichen eine effiziente Suche im Internet, doch ihre Fähigkeit zur Kategorisierung kann nicht mit menschlicher Präzision mithalten. Seitenbetreiber müssen ihre Websites für Crawler optimieren, um ein gutes Ranking in Suchmaschinen zu erreichen.

Häufige Fragen und Antworten

Warum werden Crawler verwendet?

Crawler werden verwendet, um das Internet systematisch nach neuen Seiten und geänderten Seiten zu durchsuchen. Sie spielen eine wichtige Rolle für Suchmaschinen, die Informationen bereitstellen möchten. Darüber hinaus werden Crawler auch von anderen Organisationen und Unternehmen eingesetzt, um Dokumente zu sammeln und zu analysieren.

Wie funktionieren Crawler?

Crawler sind Bots, die autonom Webseiten besuchen und URLs speichern. Sie folgen den Verlinkungen und sammeln Informationen wie Meta-Daten, E-Mail-Adressen und News-Feeds. Crawler können das gesamte Internet kartieren, obwohl meist nur die wichtigsten Seiten und Links besucht werden.

Welche Arten von Crawlern gibt es?

Es gibt verschiedene Arten von Crawlern. Allgemeine Crawler haben ein breites Spektrum und durchsuchen das gesamte Internet. Themenspezifische Crawler suchen gezielt nach Links und Seiten zu bestimmten Themen. Es gibt auch Crawler, die zum Data-Mining verwendet werden, um Datenbanken mit vielen Dokumenten zu erstellen.

Wann stoßen Crawler an ihre Grenzen?

Crawler stoßen an ihre Grenzen, wenn sie auf Inhalte hinter Paywalls oder Zugangsbeschränkungen zugreifen sollen. Sie können auch Probleme haben, bestimmte Seiten zu erfassen, die durch Cloaking-Techniken versteckt oder durch Teergruben verlangsamt werden. Datenschutzbedenken und das Sammeln von unerwünschten Daten können weitere Einschränkungen für Crawler darstellen.

Welche Vorteile und Nachteile haben Crawler?

Vorteile von Crawlern sind eine effiziente Suche im Internet und die Bereitstellung relevanter Suchergebnisse. Crawler ermöglichen es, eine große Menge an Informationen zu erfassen und zu kategorisieren. Nachteile sind, dass Crawler nicht so präzise wie Menschen in Bezug auf die Relevanzbewertung von Seiten sind. Seiten müssen für Crawler optimiert werden, um ein gutes Ranking in Suchmaschinen zu erzielen.